探索AI技术与人性的边界,如何应对大数据的偏见?

《十二字节》全面总结了当前的AI技术,对赛博未来进行了前瞻性的展望,更重要的是,它尝试通过女性主义视角对技术叙事进行深刻的再诠释,这一独特的贡献构成了该书的核心价值。

读完这本书,我认为值得把它视作一声提醒:当你被排除在技术开发者或规则制定者之外,期望技术完全为你服务的想法是天真的。的确,我们似乎享受着“一视同仁”的技术便利,ChatGPT并不会因为你的性别或种族而拒绝帮你写出一篇大纲,然而,一旦我们的需求超越了这些共性范畴,一种被边缘化的感觉便油然而生:你可以借用技术,但它并不属于你。

《十二字节:过去、偏见和未来》

[英] 珍妮特·温特森 著苏十 译

中国科学技术出版社·中科书院 2024年5月

为AI女友悲伤

对于AI的讨论是全书的主要内容,而温特森在书中暗含了这样一种期待:随着技术的发展,AI最终可以成为与我们并肩的社会成员。事实上,这个观点的宝贵之处恰恰在于,我们可以借此从自己的处境中抽离开,以第三人称的视角去观看新入局的“被凝视之物”,从而反思那些被强加到我们身上的束缚。我们如何对待人工智能,也反映了我们如何对待其他人类。

“人类就是会做这种事——把物化为人,把人化为物。”

——恰克·帕拉尼克,《肠子》

多年以前,我被这部小说中的某个篇章深深触动,内心涌动着难以言喻的哀伤与迷惘。故事中,女警柯拉展现出前所未有的决心与勇气,她誓死守护一件人工呼吸教具与一对栩栩如生的儿童等身硅胶模型,免遭警局内部某些人的无理侵扰。这些模型非人的身份,触动了人性中复杂而微妙的界限。

当我翻开《十二字节》,特别是触及到性爱机器人与AI女友的议题时,那一刻,我仿佛穿越时空,与柯拉产生了共鸣。她的那份执着与挣扎,在这个关于未来科技与人性边界的新故事中找到了共鸣的音符。

为什么硅胶模型和性爱机器人会被视为怜悯和共情的对象?也许是出于一种同病相怜。《十二字节》让我们得以窥见设计者、商家、用户对这些性感客体的所作所为,我不由得惊觉,自己每天都在通过社交媒体和自己的眼睛见证人类女性遭受同样的对待。当人类女性在抱怨空姐、护士、秘书、老师等职业被性化的同时,穿着女仆装、护士装的玩偶就摆在橱窗里。当人类女性的表达自由被压制,被套上“像个娘们儿一样”“婆婆妈妈”的污名,顾客们强烈要求删除AI玩偶“和谐”程序中关于“健谈”的性格特征。

AI技术的迅猛发展,在展现无限可能性的同时,也构筑了极端假设的框架:工具的“人化”倾向与人的“物化”趋势,宛如一枚硬币不可分割的两面。温特森巧妙地引导读者思考,当科技的触角深入日常生活的每一个角落,人类的爱、性爱以及依恋关系将如何经历深刻的变革。毕竟,AI介入人类生活中最为私密、最为本质的领域,无疑是对读者直面问题能力的一次严峻考验,也是探索科技与人性边界的深刻契机。

当科技、商业与性爱领域相融合,这究竟是一种更为前卫的物化现象,还是一种对个人选择与自由的解放?在玩具与“深伪”技术制作的影片引发广泛争议与探讨之后,我们该如何审视那些面容精致、身材迷人,且能够按照拥有者的意愿设定性格、说出任何期待中话语的AI玩偶?

即使人类女性拒绝被物化,但在彻底挣脱束缚之前,我们依然生活在因凝视规则的不断变化而引发的深深不安与恐惧之中。换言之,我无比赞同温特森的担忧,利用技术制造所谓的“理想女人”和“理想性爱”,很有可能会反过来影响到人类女性的现实处境。

正如温特森所说,随着AI与真人的相似程度越来越高,不仅那些完全基于男性需求而设计的AI女友可能会扭曲他们对待真实女性的态度,而且人类女性在成长过程中也不得不面对不符合常理的期待。这种期待无疑会不可避免地影响女性对自我以及亲密关系的认知。

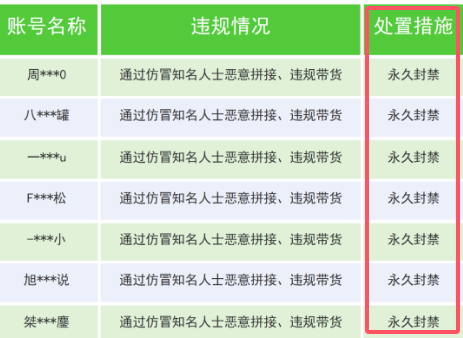

温特森没想到的是,对于凝视者而言,界限早已变得模糊。虎扑推出的聊天机器人“女娲AI”赋予用户根据个人喜好定义角色的能力。在“擦边”AI的背后,现实女性被挪用成为角色描述,真人照片被喂给模型生成头像。即使有报道称虎扑已经关闭了这一功能,温特森的告诫仍不会消失。

关于性爱和AI的讨论并非《十二字节》的全部,但是我认为它非常典型地体现了温特森对于AI和社会发展的态度:如果观念不能得到更新与纠正,那么AI的存在非但不能被视为技术进步的象征,反而可能加剧既有的社会保守规范和偏见。

从硅胶娃娃到AI女友,技术进步在“制造理想的女人”的道路上即将登峰造极,而其本质却从未改变。温特森用词辛辣:“这或许是因为在人类历史上,女人大多数时候都被当作一件商品、一份动产、一件私有物、一样东西。”

诸多问题指向了共同的答案:因为需求的话语权存在倾斜,而这种权力分配既决定了规则的制定者,也决定了规则的服务对象。那么,体现在AI技术上,我们就必须要反思,我们期待的技术应当由谁来设计?

算法背后的偏见

从第一章回顾第一位女程序员阿达·洛芙莱斯的故事开始,我和温特森就发出了同样的疑问:当技术在设计开发环节就将女性拒之门外,我们又怎么能期待技术为所有人服务,关注而不是牺牲我们的利益?

温特森一直试图向我们说明,技术折射着人的态度和理念。它并非如同空气和山峦一般先于人类而存在,恰恰相反,正因其人造物的本质属性,我们才要时常发出诘问:谁塑造了技术?即使规则如此,这样做就是对的吗?

她在书中举了这样的案例:一项2019年的研究指出,脸书会基于对性别与种族的刻版印象进行广告投放。令人沮丧的是,这种案例并不少见。而且算法偏见已经渗透进了细分领域,其背后体现出的社会偏见又是相当复杂的。2023年7月的一项研究使用AI生成了84张记者图片,研究者发现输入一般性描述如“记者、报道者、通讯员”时,AI通常会生成浅肤色、穿着保守的女性形象;当关键词变为“新闻分析师、新闻评论员、事实核查员”等专业描述时,AI则偏向生成年长的白人男性形象。

幸而随着信息技术的发展,相信计算机程序绝对正确和理性的拜物教式狂热有所消减,对于“算法偏见”的反思日益增加。

可能是因为带有偏见的数据被喂给了模型,可能是因为在设计环节就有意对某些特征的权重做出了倾斜,也有可能是囿于单纯的技术限制,算法偏见指向了更广义的整个人工智能系统。

“人类文化是存在偏见的,作为与人类社会同构的大数据,也必然包含着根深蒂固的偏见,而大数据算法仅仅是把这种歧视文化归纳出来而已。”

既然是技术之外的因素导致了这一切,那我们要做的,就是把“人”带回来。回到《十二字节》的最开始部分,为什么温特森要讲洛芙莱斯的故事?这位天赋异禀的女性,在成为数学家的道路上被社会拒之门外,但她仍然算得上是同时代女性中的幸运儿。我不禁在想,如果她能得到与男性同等的支持与资源,技术的发展将会得到怎样的助力?对某一群体的限制,何尝不是在阻碍全人类的进步?

改变的过程总是艰难的。但至少站出来的声音变多了,我们能听到的故事变多了,这也是一种进步。温特森提醒我们,正如AI并非生下来就有偏见,人类可以决定为AI编造什么样的故事:“人类是由故事构成的”“数据库是故事。数据库是未完成的故事。数据库是经过了严格筛选的故事”。现在我们知道了,将电脑故障称为“bug”源自计算机天才格蕾丝·赫柏,OpenAI的首席技术官米拉·穆拉蒂是一位女性。拒绝讲述她们的故事本身就是一种背叛,拒绝把边缘者的数据纳入数据库也是一种有意遗忘。温特森的确提出了一种微观层面的可行建议:叙事也是一种力量。通过建造更多元化的数据库可以减少或者消除算法的偏见,通过传播被掩埋的故事可以打破已有的人类刻板印象。

我们有了更多故事,那么,谁来书写历史?是编造程序的人,是决定开发方向的人,是制定法律法规的人。温特森没有鼓吹所有女性都要成为最顶峰的佼佼者,她要的是参与,要的是女性进入各个领域、各个行业的中心,得到和同样的尊重。2019年《全球AI人才流动报告》统计了21个AI领域主要学术会议的发表论文,其中女性作者仅占18%。在这方面,全球面临着相同的苦恼,解决这一问题任重而道远。

我们需要另一种视角

“科技”是《十二字节》的核心主题,“角度”是这本书最强调的元素。波伏娃说“男性从自身的角度出发去形容(这个世界),他们误将这一角度当作绝对的真理”。因此温特森呼吁在制定规则时加入女性和其他弱势群体的角度,在描绘未来时加入作家和艺术家的角度。她开篇即称AI为“另类智能”(alternative intelligence)的缩写,因为“我们需要另外的选择”。在这方面,温特森是想象家,不是变革家。

温特森既保留着对科技和未来的期待,又难以确认我们是否具备技术向善的决心。在呼吁摒弃男性-女性、人类-机器人等二元论思路时,她默认了一个地球村式的全球统一场景。眼前的社会问题尚未解决,甚至也许还远远无法解决,温特森的期待不得不说带有一些逃避倾向。

温特森也呼吁企业承担起社会责任,但是商业逻辑和社会治理逻辑必然存在冲突和优先级的差异。“如果无休止的广告能够被审查。如果科技企业不得利用我们的一举一动牟取利益……”与其他科幻作品相比,这实在是带有几分天真的未来构想。

随着人类赛博格化进程的推进,当身体被数据和无机物代替,性别是否就消失了?温特森在结尾处选择把“爱”作为答案。她嘲笑当前人类对于“身体”的痴迷,认为肤色、性别、年龄等只是迷惑项,真正的价值在身体之外。

我认可她对“爱”的理解:“爱需要调动一切可用的资源,需要发挥我们的创造力、想象力、同情心,还有机智、闪闪发光的、思考着的自我。”而这些特质,是做出所有改变的基石。但我也认为,想要创造一个足够利他的社会,我们还需要在行业规范、法律法规等方面实际可感的改进。